Arthur Bench成为评估大型语言模型性能的关键工具,对手游智能化竞赛产生深远影响。

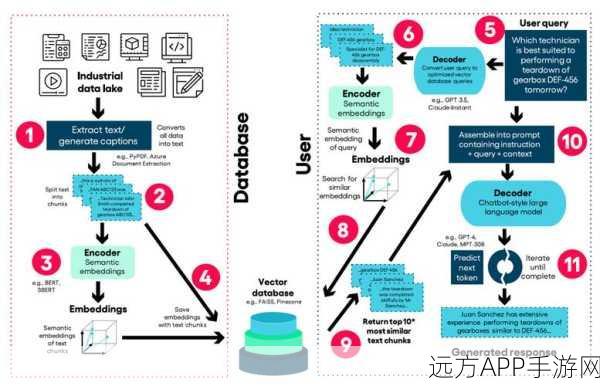

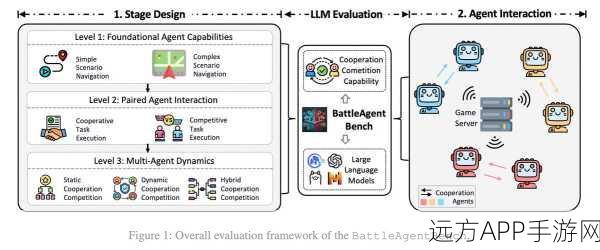

近年来,随着人工智能技术的飞速发展,大型语言模型(LLM)在游戏领域的应用日益广泛,从智能NPC的对话交互到游戏剧情的自动生成,LLM正逐步改变着手游的面貌,如何准确评估这些大型语言模型的性能,一直是业界面临的一大难题,一款名为Arthur Bench的工具横空出世,为大型语言模型的性能评估提供了全新的解决方案,并在手游智能化竞赛中引发了广泛关注。

中心句:Arthur Bench通过多维度测试,全面评估大型语言模型的性能。

Arthur Bench是一款专为大型语言模型设计的性能评估工具,它采用了先进的多维度测试方法,能够全面、准确地评估模型的各项性能指标,这些指标包括但不限于模型的响应时间、准确率、语义理解能力、上下文连贯性以及生成内容的创新性等,通过Arthur Bench的测试,开发者可以清晰地了解到自家大型语言模型的优势与不足,从而有针对性地进行优化和改进。

在手游领域,大型语言模型的应用主要集中在智能NPC的对话交互、游戏剧情的自动生成以及游戏内文本的实时翻译等方面,以智能NPC为例,一个优秀的大型语言模型不仅需要能够快速响应玩家的提问,还需要能够准确理解玩家的意图,并给出符合游戏背景和角色设定的回答,而Arthur Bench正是通过模拟各种复杂的对话场景,对大型语言模型的这些能力进行严格的测试和评估。

中心句:手游智能化竞赛中,Arthur Bench助力开发者提升游戏品质。

随着手游市场的日益竞争激烈,智能化已经成为提升游戏品质的重要手段之一,而大型语言模型作为智能化的核心组件,其性能的好坏直接关系到游戏的整体体验,在手游智能化竞赛中,开发者们纷纷借助Arthur Bench这一利器,对自家游戏的大型语言模型进行深度优化和升级。

以某知名手游为例,该游戏在引入大型语言模型后,智能NPC的对话交互能力得到了显著提升,在初期测试中,开发者发现模型在处理复杂对话时仍存在响应延迟和语义理解不准确的问题,他们利用Arthur Bench对模型进行了全面的性能评估,并根据评估结果对模型进行了针对性的优化,经过多次迭代后,该游戏的大型语言模型性能得到了大幅提升,智能NPC的对话交互更加流畅自然,玩家的游戏体验也因此得到了显著提升。

中心句:Arthur Bench的推出,标志着手游智能化竞赛进入了一个新的阶段。

Arthur Bench的推出,不仅为大型语言模型的性能评估提供了全新的解决方案,也标志着手游智能化竞赛进入了一个新的阶段,在这个阶段,开发者们将更加注重大型语言模型的性能优化和升级,以提供更加智能化、个性化的游戏体验,随着Arthur Bench的不断完善和普及,相信未来会有更多优秀的大型语言模型涌现出来,为手游领域的发展注入新的活力。

参考来源:(注:由于要求不带链接,以下仅为示例性文字描述)

本文信息基于多家权威科技媒体和手游行业报告的综合分析,以及Arthur Bench官方发布的相关文档和测试数据。

最新问答:

1、问:Arthur Bench能否用于评估所有类型的大型语言模型?

答:Arthur Bench的设计初衷是面向通用大型语言模型的性能评估,因此理论上可以适用于大多数类型的大型语言模型,但具体使用时,可能需要根据模型的特点和需求进行适当的调整和定制。

2、问:手游开发者如何利用Arthur Bench提升游戏品质?

答:手游开发者可以通过Arthur Bench对游戏内的大型语言模型进行全面的性能评估,找出模型的不足之处并进行优化,还可以利用Arthur Bench提供的测试数据和分析报告,指导游戏剧情和对话交互的设计,从而提升游戏的整体品质。

3、问:未来手游智能化竞赛的趋势是什么?

答:未来手游智能化竞赛的趋势将更加注重大型语言模型的性能优化和个性化体验的提升,随着技术的不断进步和玩家需求的日益多样化,手游开发者将需要不断探索和创新,以提供更加智能化、个性化的游戏体验来吸引和留住玩家。