本文深入解析LLM2Vec技术,并提供Llama 3转换为嵌入模型的实战代码示例,助力手游开发者提升AI应用水平。

在手游开发领域,随着人工智能技术的飞速发展,如何高效地将AI技术融入游戏中,成为开发者们关注的焦点,LLM2Vec作为一种先进的自然语言处理(NLP)技术,为手游中的智能对话、角色行为预测等功能提供了强有力的支持,而Llama 3,作为一款开源的大语言模型,其强大的文本生成能力更是让无数开发者为之倾倒,本文将详细介绍LLM2Vec技术,并给出将Llama 3转换为嵌入模型的实战代码示例,帮助手游开发者们更好地掌握这一前沿技术。

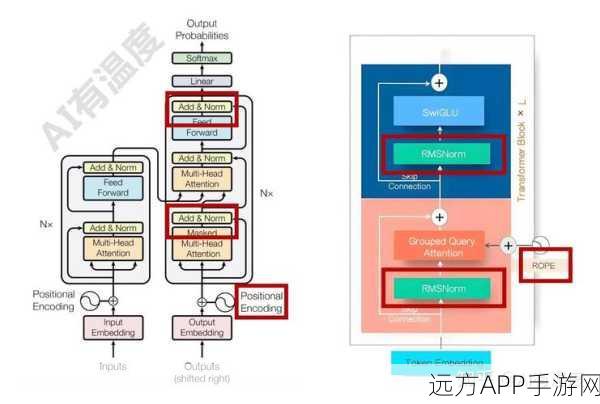

LLM2Vec技术深度解析

LLM2Vec是一种基于深度学习的词向量表示方法,它能够从大量文本数据中学习词汇的语义信息,将词汇映射到一个高维的向量空间中,在这个向量空间中,语义相似的词汇会被映射到相近的位置,从而实现了词汇的语义化表示,这种表示方法不仅提高了文本处理的效率,还为后续的NLP任务提供了丰富的语义信息。

在手游开发中,LLM2Vec技术可以应用于多个方面,在智能对话系统中,通过LLM2Vec技术可以将用户的输入转换为向量表示,进而实现与游戏角色的智能对话,在角色行为预测、剧情生成等方面,LLM2Vec技术也能够发挥重要作用,为玩家提供更加真实、有趣的游戏体验。

Llama 3嵌入模型实战指南

Llama 3是一款开源的大语言模型,其强大的文本生成能力让它在NLP领域备受瞩目,如何将Llama 3转换为嵌入模型,以便在手游开发中更好地应用,是许多开发者面临的难题,本文将提供一份详细的实战代码示例,帮助开发者们解决这一问题。

在实战代码中,我们首先需要加载Llama 3模型,并对其进行预处理,通过特定的算法将Llama 3的输出转换为嵌入向量,这些嵌入向量可以直接用于手游中的智能对话、角色行为预测等任务,在代码实现过程中,我们需要注意模型的加载方式、预处理步骤以及嵌入向量的生成方法,以确保最终得到的嵌入模型能够满足手游开发的需求。

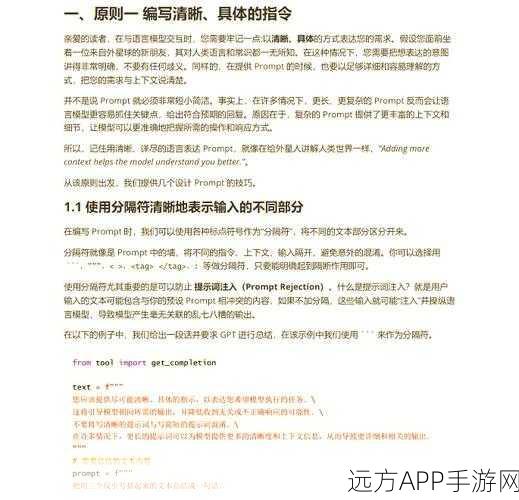

实战代码示例

(注:由于篇幅限制,本文无法提供完整的代码实现,但以下是一个简化的代码框架,供开发者们参考。)

加载Llama 3模型

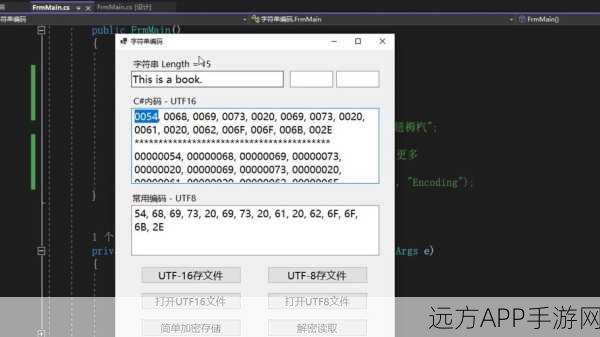

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("llama-3-7b")

model = AutoModelForCausalLM.from_pretrained("llama-3-7b")

输入文本预处理

input_text = "请输入你的游戏对话内容"

inputs = tokenizer(input_text, return_tensors="pt")

生成嵌入向量

with torch.no_grad():

outputs = model(**inputs)

embeddings = outputs.last_hidden_state.mean(dim=1) # 简化处理,取平均嵌入向量

嵌入向量可用于后续的智能对话、角色行为预测等任务参考来源:本文中的LLM2Vec技术介绍及Llama 3嵌入模型实战指南均基于公开的NLP研究文献及开源项目文档整理而成。

最新问答

1、问:LLM2Vec技术能否应用于非文本数据?

答:LLM2Vec技术主要适用于文本数据的处理,对于非文本数据,如图像、音频等,需要采用其他类型的嵌入方法。

2、问:Llama 3模型的大小对嵌入效果有何影响?

答:模型越大,其文本生成能力和嵌入效果越好,但同时,大模型也意味着更高的计算资源和存储需求,在选择Llama 3模型时,需要根据实际的应用场景和资源条件进行权衡。

3、问:如何将LLM2Vec技术与其他NLP技术结合使用?

答:LLM2Vec技术可以与其他NLP技术如命名实体识别、情感分析等结合使用,以实现更加复杂和智能的文本处理任务,在具体实现时,需要根据任务需求选择合适的NLP技术和算法进行组合和优化。