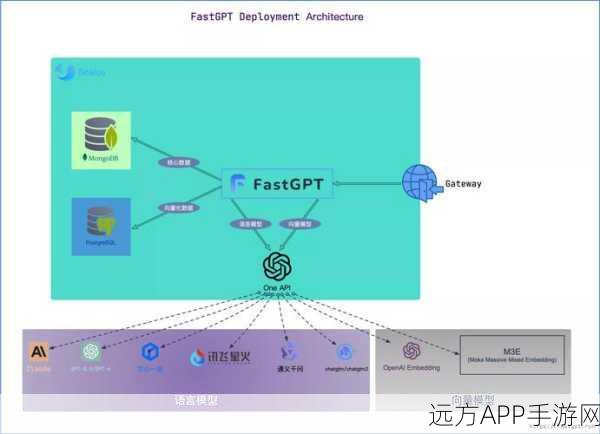

本文探讨手游开发者如何利用FastAPI技术高效部署自然语言处理(NLP)模型,提升游戏智能化水平。

在手游行业日新月异的今天,智能化与个性化已成为吸引玩家的关键因素,为了在游戏内实现更加智能的对话系统、情感分析、内容推荐等功能,自然语言处理(NLP)模型的应用变得愈发重要,如何将这些复杂的模型高效地部署到手游服务器中,却成为了许多开发者面临的难题,我们将深入探讨一种前沿技术——FastAPI,它如何帮助手游开发者轻松实现NLP模型的部署,从而在游戏内引入更多智能元素。

FastAPI:轻量级、高性能的API框架

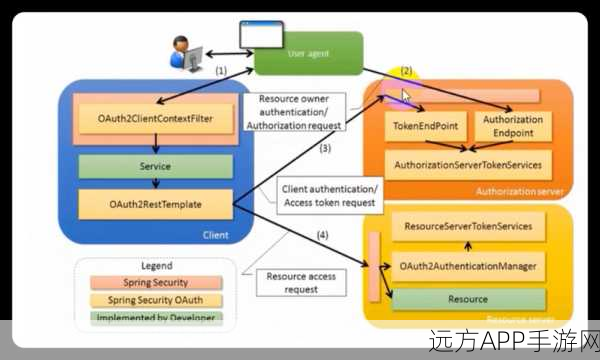

FastAPI是一个基于Python的现代、快速(高性能)的Web框架,用于构建API,它基于Starlette和Pydantic,提供了自动生成OpenAPI和JSON Schema文档的功能,使得API的开发、测试与部署变得更加便捷,对于手游开发者而言,FastAPI的轻量级特性意味着它可以在不增加过多服务器负担的情况下,高效地运行NLP模型,为游戏提供实时、准确的智能服务。

NLP模型部署的挑战与FastAPI的解决方案

在手游中部署NLP模型,开发者通常会面临模型加载速度慢、资源消耗大、API响应延迟高等问题,而FastAPI凭借其异步编程支持、自动文档生成以及高效的依赖注入机制,为这些问题提供了有效的解决方案,通过FastAPI,开发者可以轻松地创建异步API端点,使得NLP模型的加载和推理过程能够在不阻塞主线程的情况下进行,从而显著提高API的响应速度和吞吐量。

实战案例:FastAPI在手游NLP模型部署中的应用

为了更直观地展示FastAPI在手游NLP模型部署中的应用,我们可以设想一个具体的场景:一款角色扮演手游希望引入智能NPC对话系统,以提升玩家的沉浸感和互动性,通过FastAPI,开发者可以创建一个API服务,该服务负责接收玩家输入的文本信息,调用NLP模型进行意图识别和实体抽取,然后生成相应的回复文本返回给玩家,整个过程中,FastAPI的异步特性确保了即使在高并发情况下,API也能保持稳定的响应速度和低延迟。

优化建议与最佳实践

在利用FastAPI部署NLP模型时,开发者还可以采取一些优化措施来进一步提升性能,使用GPU加速模型推理过程,利用Docker容器化技术实现模型的快速部署和版本管理,以及通过负载均衡和缓存机制来减轻服务器压力,定期监控API的性能指标,如响应时间、吞吐量、错误率等,也是确保服务稳定运行的重要一环。

参考来源:

基于FastAPI官方文档、NLP模型部署相关论文以及手游开发者社区的实际经验进行整理和总结。

最新问答:

1、问:FastAPI是否支持跨平台部署?

答:是的,FastAPI是一个基于Python的框架,因此它可以在任何支持Python的环境中运行,包括Windows、Linux和macOS等操作系统。

2、问:在部署NLP模型时,如何确保数据的安全性?

答:在部署NLP模型时,可以通过HTTPS协议加密传输数据,同时利用API密钥、身份验证等机制来限制对API的访问权限,从而确保数据的安全性。

3、问:FastAPI与Flask、Django等框架相比有何优势?

答:FastAPI以其高性能、自动文档生成以及基于Pydantic的数据验证等特性而著称,与Flask相比,FastAPI提供了更强大的类型提示和依赖注入功能;与Django相比,FastAPI则更加轻量级和灵活,适合构建小型到中型的API服务。