AI手游解题大赛结果揭晓,新基准测试显示AI模型在解题能力上存在不足。

备受瞩目的AI手游解题大赛圆满落幕,大赛结果却揭示了一个令人意外的现象:当前主流的AI模型在解决手游中的复杂数学问题时,表现出了明显的解题能力不足,这一发现源自大赛主办方最新推出的基准测试,该测试旨在全面评估AI在手游场景下的数学解题能力。

中心句:AI手游解题大赛背景及目的介绍。

本次AI手游解题大赛吸引了众多国内外顶尖AI团队参与,他们带来了各自研发的最新AI模型,旨在通过实战比拼,探索AI在手游领域的应用潜力,大赛不仅设置了丰厚的奖金池,还邀请了多位行业专家担任评委,确保比赛的公正性和权威性,主办方希望通过此次大赛,推动AI技术在手游领域的创新应用,也希望通过新基准测试的推出,为AI模型的数学解题能力提供一个客观的评价标准。

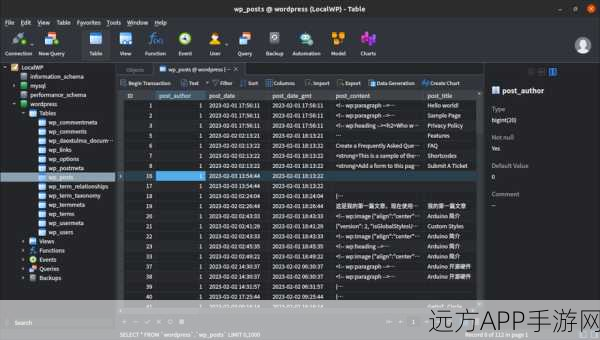

中心句:新基准测试内容及其揭示的问题。

新基准测试涵盖了手游中常见的数学题型,包括代数、几何、概率等多个领域,题目难度从简单到复杂不等,测试结果显示,尽管AI模型在解决一些基础数学问题时表现出色,但在面对复杂题型时,其解题能力却大打折扣,部分AI模型在解题过程中出现了明显的逻辑错误,甚至无法给出正确的答案,这一现象引发了业内人士的广泛关注和讨论,大家纷纷表示,AI在手游领域的数学解题能力仍有待提升。

中心句:AI模型解题能力不足的原因分析。

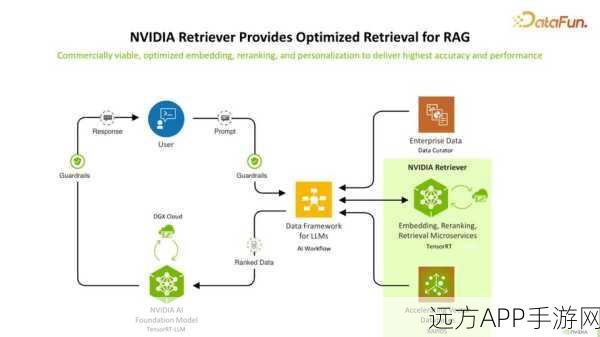

针对AI模型在解题能力上的不足,多位专家给出了自己的见解,他们认为,这主要是由于当前AI模型在训练过程中过于依赖大数据和深度学习算法,而忽视了数学逻辑和推理能力的培养,手游中的数学题型往往具有高度的灵活性和多样性,而AI模型在面对这些题型时,往往缺乏有效的应对策略和解题技巧,要想提升AI在手游领域的数学解题能力,就需要在模型训练过程中注重数学逻辑和推理能力的培养,还需要加强对手游数学题型的深入研究和分析。

中心句:AI在手游领域的应用前景及改进方向。

尽管AI模型在解题能力上存在一定的不足,但其在手游领域的应用前景依然广阔,随着技术的不断进步和应用的不断深入,AI有望在手游领域发挥更大的作用,AI可以应用于手游的智能推荐系统,根据玩家的游戏习惯和喜好,为其推荐合适的游戏内容和活动;AI还可以用于手游的自动化测试和优化,提高游戏的质量和稳定性,为了提升AI在手游领域的数学解题能力,未来可以从以下几个方面进行改进:一是加强AI模型的数学逻辑和推理能力培养;二是深入研究和分析手游中的数学题型,为AI模型提供更加有效的解题策略和技巧;三是推动AI与数学领域的交叉融合,探索新的算法和技术手段,以应对手游中更加复杂和多样的数学题型。

参考来源:本次大赛主办方发布的官方报告及多位行业专家的访谈记录。

最新问答:

1、问:AI在手游领域的数学解题能力为何不足?

答:主要是由于当前AI模型在训练过程中过于依赖大数据和深度学习算法,而忽视了数学逻辑和推理能力的培养。

2、问:未来如何提升AI在手游领域的数学解题能力?

答:可以从加强AI模型的数学逻辑和推理能力培养、深入研究和分析手游中的数学题型、推动AI与数学领域的交叉融合等方面进行改进。

3、问:AI在手游领域还有哪些潜在的应用?

答:AI可以应用于手游的智能推荐系统、自动化测试和优化等方面,未来还有望在更多领域发挥更大的作用。