本文深入解析大模型Fine-tuning的三种微调方式,为手游开发者提供AI升级的关键指导。

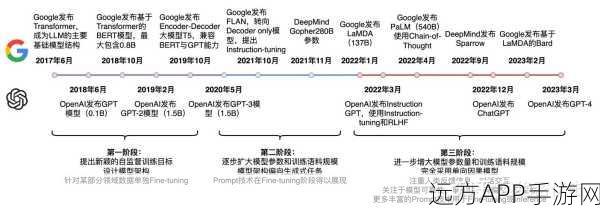

在手游行业日益激烈的竞争中,游戏AI的智能化水平成为了衡量游戏品质的重要标准之一,为了提升游戏AI的表现力,大模型Fine-tuning技术应运而生,本文将详细解析Fine-tuning的三种微调方式,帮助手游开发者更好地理解和应用这一技术,从而在游戏AI的升级之路上迈出坚实的一步。

一、基础微调:快速适应游戏场景

基础微调是大模型Fine-tuning中最直接、最基础的一种方式,它通过对大模型进行少量的参数调整,使其能够快速适应特定的游戏场景,在手游开发中,开发者可以利用基础微调技术,将通用的大模型转化为针对游戏内特定任务(如NPC对话、战斗策略等)的专用模型,这种方式不仅保留了大模型的泛化能力,还显著提高了模型在游戏场景中的表现力和适应性。

中心句:基础微调通过少量参数调整,使大模型快速适应游戏场景,提高游戏AI的表现力和适应性。

二、迁移学习微调:跨领域知识共享

迁移学习微调是一种更为高级的大模型Fine-tuning方式,它利用大模型在某一领域(如自然语言处理)学到的知识,通过微调将其应用到另一领域(如游戏AI)中,在手游开发中,开发者可以借鉴这一思路,将在大规模语料库上训练好的大模型迁移到游戏场景中,通过微调使其具备游戏特有的知识和能力,这种方式不仅降低了模型训练的成本,还加速了游戏AI的研发进程。

中心句:迁移学习微调利用跨领域知识共享,降低模型训练成本,加速游戏AI研发进程。

三、多任务学习微调:提升模型综合能力

多任务学习微调是一种更为复杂但效果显著的大模型Fine-tuning方式,它通过在训练过程中同时考虑多个任务(如游戏内的对话生成、战斗决策等),使模型能够学习到这些任务之间的共同特征和关联信息,在手游开发中,开发者可以利用多任务学习微调技术,将游戏内的多个任务整合到一个模型中,通过微调提升模型的综合能力和泛化性能,这种方式不仅提高了游戏AI的智能化水平,还增强了模型的鲁棒性和稳定性。

中心句:多任务学习微调通过整合多个任务,提升模型综合能力和泛化性能,增强游戏AI的智能化水平。

参考来源:

本文所提及的大模型Fine-tuning技术及其三种微调方式,均基于当前学术界和工业界的最新研究成果和实践经验,通过深入分析和总结这些成果和经验,本文旨在为手游开发者提供一份全面、实用的技术指南。

最新问答:

1、问:手游开发者在选择大模型Fine-tuning方式时,应考虑哪些因素?

答:手游开发者在选择大模型Fine-tuning方式时,应综合考虑游戏类型、任务复杂度、模型规模、训练成本以及时间要求等因素,不同类型的游戏和任务对模型的要求不同,因此需要根据实际情况选择最合适的微调方式。

2、问:基础微调与迁移学习微调相比,有哪些优缺点?

答:基础微调具有快速适应游戏场景、保留大模型泛化能力等优点,但可能面临模型过拟合、训练成本较高等问题,而迁移学习微调则能够降低模型训练成本、加速研发进程,但可能需要更多的数据和计算资源来支持跨领域的知识共享。

3、问:多任务学习微调在游戏AI开发中有哪些应用场景?

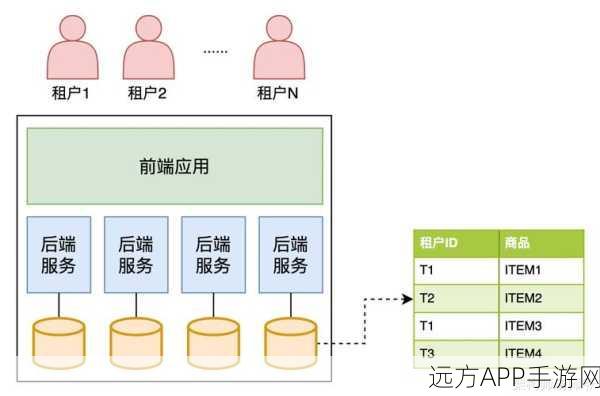

答:多任务学习微调在游戏AI开发中有着广泛的应用场景,如NPC对话生成、战斗决策制定、游戏内物品推荐等,通过整合这些任务到一个模型中并进行微调,可以显著提升游戏AI的智能化水平和综合能力。